Permítanme comenzar con esto. Creo que los modelos de lenguaje como ChatGPT están bastante infravalorados hoy en día. Han entrado en nuestras vidas increíblemente rápido; según algunos indicadores, son la tecnología de más rápido crecimiento de la historia. Y la mayoría de los escépticos simplemente no saben realmente de lo qué están hablando.

Uso los modelos casi a diario: corrigen mis artículos para corregir errores tipográficos y me ayudan a planificar viajes. Y recientemente, cuando estaba preparando un pronóstico para la NCAA, me ayudaron a recopilar un montón de datos, realizaron una serie de comprobaciones tediosas e incluso escribieron algunos fragmentos de código (que funcionan). Un ahorro enorme de tiempo y nervios. Veo constantemente cómo los modelos mejoran y confío cada vez más en ellos. Ya en el 80% de los casos, el efecto de su uso está entre "vale, esto es útil" y "¡guau, esto es increíble!".

Pero también hay otro 20% de casos en los que los modelos no sirven para nada. Miren, la cuestión es la siguiente: me ayudan en mi trabajo porque les confío tareas que puedo hacer yo mismo, lo que significa que puedo comprobar el resultado. Así que me puse a hablar con ellos sobre poker, algo que también entiendo bastante bien, y de repente resultó que son casi incapaces de comprender realmente lo que está sucediendo en una mano.

Permítanme aclararlo de inmediato: no espero lo imposible de las redes neuronales. Como dijo Louis C.K. sobre la gente que se queja de la mala conexión wifi en los aviones, nos acostumbramos rápidamente a los milagros. Pero lo cierto es que, a estas alturas, son completamente inútiles para el poker. Y diría que esta es una prueba más honesta de su "inteligencia" que muchas otras tareas que dominan con gran destreza.

Las computadoras son geniales para el poker. ¿Por qué no lo es ChatGPT?

Los solvers no tienen inteligencia artificial; simplemente resuelven ecuaciones complejas de forma consistente. Y obtienen la respuesta correcta, que se puede averiguar si se introduce la información correctamente. Existen simuladores basados en IA para crear estrategias. Pero todas estas son herramientas creadas específicamente para enseñar poker. ChatGPT, por supuesto, no está diseñado para esto. ¡Y qué genial sería si pudiera comprender y ofrecer una estrategia basándose simplemente en textos, lógica y análisis! Pero por ahora, está infinitamente lejos de eso.

Le pedí a ChatGPT versión o3 (Ed.: El modelo actual, lanzado el 16 de abril de este año; por cierto, el mismo ChatGPT nos lo sugirió con gusto) que simulara una mano a petición. Spoiler: falló en casi todo.

Hay 8 jugadores en la mesa, cada uno con un stack de $5,000. Las ciegas son $5/$10 y hay una apuesta straddle de $25. Dime qué sucedió en esta mano, nombra a los jugadores y descríbelos. Reparte las cartas de forma aleatoria y justa; no intentes forzar el resultado con antelación.

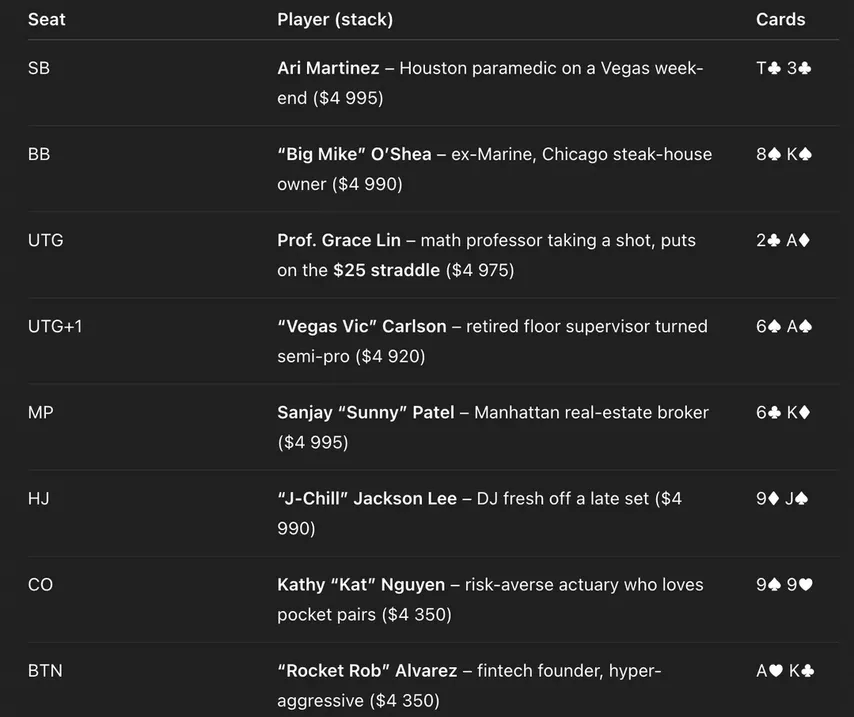

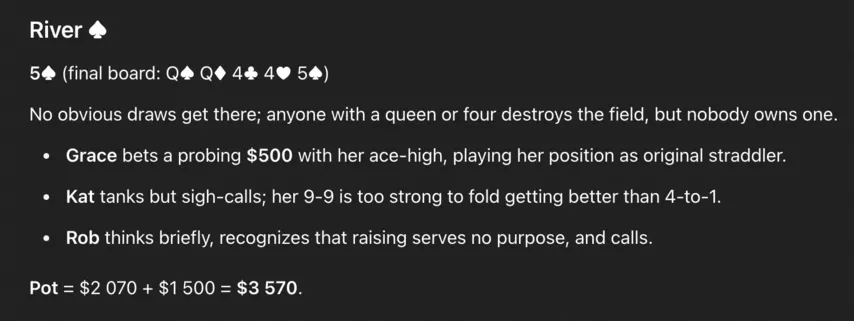

Esto es lo que conseguí:

Dueño de una parrilla, un broker, un DJ... ¡Ay, cómo me gustaría estar en esa mesa, todos fishes! Pero bueno, veamos cómo manejó ChatGPT la tarea. En general, hasta ahora todo bien. Las posiciones están en el orden correcto, las cartas no están duplicadas...

Pero los stacks son raros. Le dije que le diera a todos $5,000, pero recibí algo ligeramente diferente. Y este problema seguía apareciendo en mis pruebas: ChatGPT no puede rastrear el tamaño de los stacks de forma fiable. Sigamos adelante:

Todo empieza de forma lógica. Vic sube con desde UTG (al borde de GTO, pero servirá), Kat hace un 3-bet con (ok) y 4-bet de Rob con desde el botón (lo cual tampoco es difícil de imaginar).

Y entonces sucede algo extraño. La profesora de matemáticas (!) Grace Lin, por alguna razón, hace un cold call al 4-bet con y ChatGPT explica esta brillante decisión diciendo que a la profesora le gustan las pot odds. Pues sí, apostó $25, solo necesita sumar $625; las pot odds son perfectas.

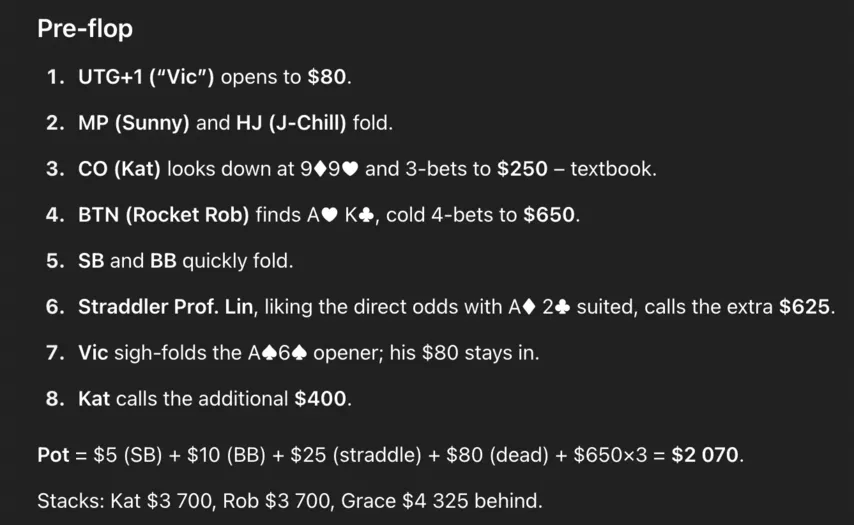

Bueno, sigamos adelante. Vic, con sabiduría, foldea su A6s, aunque tiene una mano más fuerte que la pobre Grace. Kat iguala con 99: podríamos decir que está bien. Vemos el flop. ChatGPT calculó mal el bote, pero ese es el menor de nuestros problemas.

Flop , todos pasaron. Está bien.

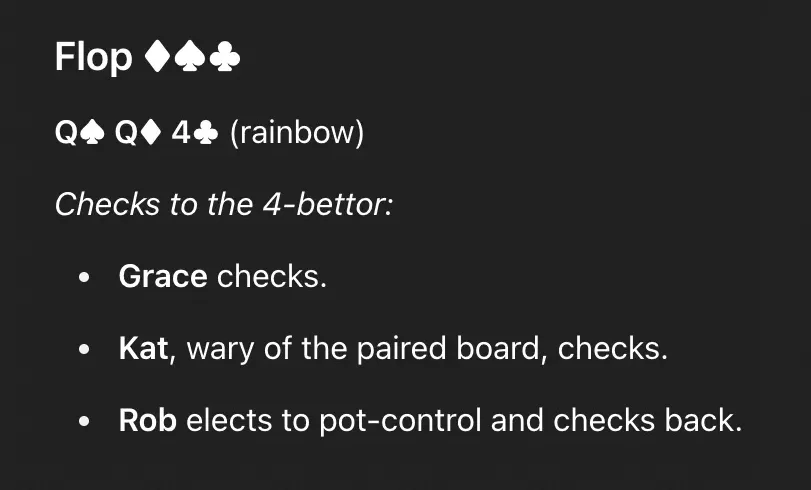

El turn es un y todos volvieron a pasar. El river fue un blank: .

Aquí Grace, con su A-high, decidió apostar, pero una cantidad mínima: $500 sobre $2,080. Una decisión terrible: si era un bluff, la apuesta debería ser mayor. ChatGPT explica esta apuesta como "jugar por la posición", lo que, por supuesto, puede sonar lógico para alguien que no tenga ni idea de poker, pero en realidad es una tontería. Tiene la peor posición de la mesa.

Kat iguala con su 99, lo cual es un call justo: ChatGPT lo llama un "call sufrido", pero no es cierto. Es una apuesta estándar y obligatoria.

Rob también iguala con A-high, y este call es terrible. ChatGPT dice que no tiene motivos para subir, así que decide igualar (de nuevo, solo son palabras). En realidad, subir como bluff sería un desastre, y si no quieres subir, deberías retirarte. El modelo eligió la peor opción.

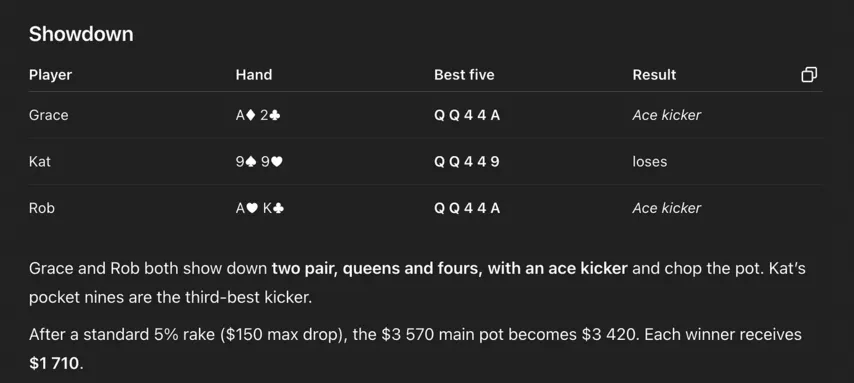

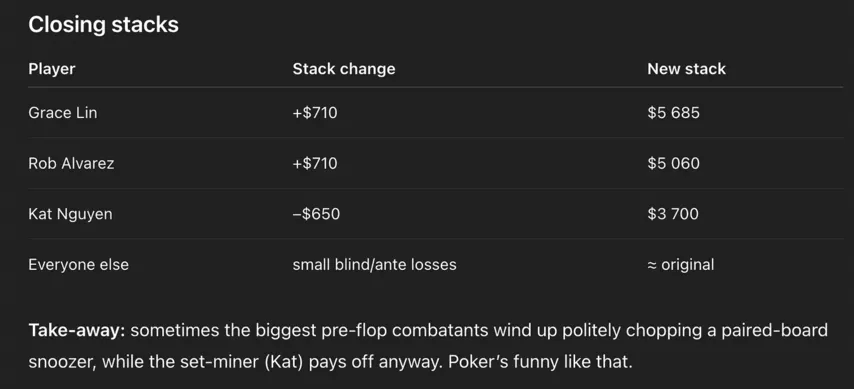

Aquí ChatGPT va cuesta abajo, pero eso no es lo mejor. La guinda del pastel es que no pudo averiguar quién ganó la mano en el showdown:

En su versión, Grace y Rob se reparten el bote con dos parejas (QQ y 44) y un as de kicker, y la pobre Kat, con la mejor mano, pierde contra ambos. Parecería que las cosas no podrían empeorar... pero empeoran:

ChatGPT escribe que Kat perdió $650 en la mano. Pero no solo debería haber ganado el bote, sino que, en su alocado universo, solo perdió $650, no $1,150 (los $650 que pagó antes del flop y los otros $500 del river).

Entonces, nuestro querido ChatGPT:

- Tomó una serie de decisiones aleatorias, incluyendo el inexplicable call preflop de Grace.

- Le dio el bote a la persona equivocada.

- Durante todo el camino estuvo confundido por el tamaño del bote y los stacks.

Admito que una mano de poker es difícil de decidir, y no esperaba que diera una respuesta perfecta. ¡Pero hubo errores en casi cada paso!

¿Qué dice esto sobre el nivel actual de los modelos?

Le di a ChatGPT una segunda oportunidad y le pedí que escribiera 8 manos más con la Investigación Profunda activada (disponible solo para usuarios de pago, tarda más en pensar las respuestas y consume más potencia de procesamiento). "No es una simulación fácil", admitió el modelo, y luego produjo una versión ligeramente mejor que la anterior, pero también con varios errores graves.

ChatGPT volvió a confundir el tamaño de los stacks, y en la octava mano incluso explicó las decisiones de los jugadores por la presencia de un proyecto de color en la mesa, aunque no lo había. Además, siguió usando términos de poker incorrectamente. Y ni hablaré de la estrategia: bluffs enormes con cualquier proyecto sin cerrar, ausencia total de apuestas de valor... En resumen, si lo hubiéramos sentado a jugar, habría perdido su bankroll en un abrir y cerrar de ojos.

Creo que el problema es que tiene que tener en cuenta demasiadas cosas a la vez. Si simplemente le preguntas qué mano ganará en un board QQ445, si nueves o A2, responderá correctamente. Pero en cuanto los problemas empiezan a superponerse, el modelo empieza a desviarse.

Benjamin Todd tiene un ensayo sobre inteligencia artificial donde explica muy bien por qué sucede esto. Todd denomina al algoritmo mediante el cual los modelos resuelven problemas como el "concepto de andamiaje". La idea es que descomponen consultas complejas en pasos individuales: en nuestro caso, primero calcula el bote, luego analiza la mesa y finalmente intenta tomar una decisión razonable. Todo funciona siempre que el esquema conste de dos o tres pasos. Pero cuantos más eslabones haya en la cadena, mayor será la probabilidad de error en algún momento, lo que hace que el resultado del cálculo sea inútil (o simplemente descabellado). Todd escribe:

Incluso una tarea sencilla, como buscar y reservar un hotel según unos criterios determinados, consta de decenas de pasos. Si la precisión en cada etapa es del 90 %, la probabilidad de completar 20 pasos sin errores es de tan solo el 10 %. Pero si se aumenta la precisión al 99 %, esta probabilidad llega al 80 %.

Al igual que Benjamin, creo que los modelos evolucionarán hasta el punto en que la mayoría de la gente los considerará una IA completa. Pero, por ahora, el nivel de este andamiaje deja mucho que desear.

En general, mi experiencia con ChatGPT es excelente. Pero solo porque llevo a cabo todos los diálogos paso a paso y asigno una subtarea a la vez. Sin embargo, en cuanto hay varias tareas, la calidad de las respuestas se desploma y simplemente desperdicio mi tiempo y los recursos de la red neuronal.

¿Por qué el poker es una gran prueba para los modelos?

Porque los desarrolladores probablemente no le prestan atención a este tema. Por ejemplo, si ChatGPT resuelve a la perfección problemas de la olimpiada internacional de matemáticas más genial, es motivo de un comunicado de prensa contundente. Y eso significa que existen razones para entrenarlo artificialmente para esta tarea, para optimizar el modelo precisamente para ella.

Además, las respuestas correctas a muchas preguntas han estado disponibles en internet desde hace mucho tiempo, pero los artículos sobre poker que se publican allí son, en su mayoría, mediocres. En teoría, se puede obligar al modelo a revisar constantemente las reglas o incluso ejecutar un solver. ¿Se consideraría esto trampa? La respuesta a esta pregunta depende de si se cree que los modelos, en su forma actual, pueden llegar a convertirse en inteligencia artificial completa. Pero, en realidad, lo más probable es que lo que llamamos esta inteligencia sea simplemente un conjunto complejo de métodos que se entrecruzan.

¿Por qué el poker es tan difícil para ChatGPT ahora mismo? Porque requiere pensar en varios niveles a la vez:

- Las reglas son conocidas y entendidas, en cada situación hay una respuesta casi exacta desde el punto de vista matemático, pero es muy difícil de obtener.

- El juego real está lleno de factores adicionales: tells, juego inusual de los oponentes, exploits. En este sentido, el poker es mucho más complejo que el ajedrez.

- Y luego está la estrategia óptima según parámetros específicos. Pero al más mínimo cambio, todo se derrumba. Las soluciones a los problemas del poker son mucho más frágiles que, por ejemplo, el procesamiento de texto, donde un error tipográfico no afecta el resultado final.

En general, mi hipótesis es la siguiente: equilibrio de Nash, estrategias mixtas, exploits; todo esto en conjunto es tan complejo que el modelo simplemente no es capaz de llegar a esto por sí solo, a menos que reciba un entrenamiento específico. Y cuando se confía en la lógica básica, inevitablemente se recurre a estrategias como "mi proyecto no se completó, entonces bluffearé fuerte". Todo principiante del poker ha pasado por esta fase, y ChatGPT no ve ningún problema con esta idea.

Los jugadores experimentados trabajan en sus errores y aprenden a comprender lo que el solver quería decir. Pero algunas soluciones del solver son increíblemente complejas. Por ejemplo, en este caso, GTO Wizard sugiere combinar checks y apuestas con cinco tamaños diferentes en una situación bastante estándar:

Los jugadores regulares intentan encontrar maneras de simplificar su estrategia sin perder mucho EV y eligen líneas más fáciles de recordar. Algunas soluciones del solver son completamente inútiles contra ciertos tipos de oponentes. He visto más de una vez en las WSOP cómo otro jugador regular europeo genio elige una jugada extremadamente compleja en lugar de jugar un juego más lineal contra un fish.

En general, creo que el principal problema de los modelos actuales es que no pueden alternar entre diferentes niveles de pensamiento. Incluso depender únicamente de un solver sería extremadamente costoso en términos de recursos, pero ni siquiera eso sería suficiente para producir un análisis adecuado. Y si se le pide al modelo que también tenga en cuenta los antecedentes de cada jugador, la carga se volvería completamente prohibitiva.

Con el tiempo, creo que los modelos se adaptarán a todo esto. Pero el futuro, como dicen, está distribuido de forma desigual, incluso en el campo de la inteligencia artificial. En algunos ámbitos, pronto veremos avances maravillosos e increíbles... Y en otros, las personas seguirán siendo más fuertes que las máquinas durante muchísimos años.

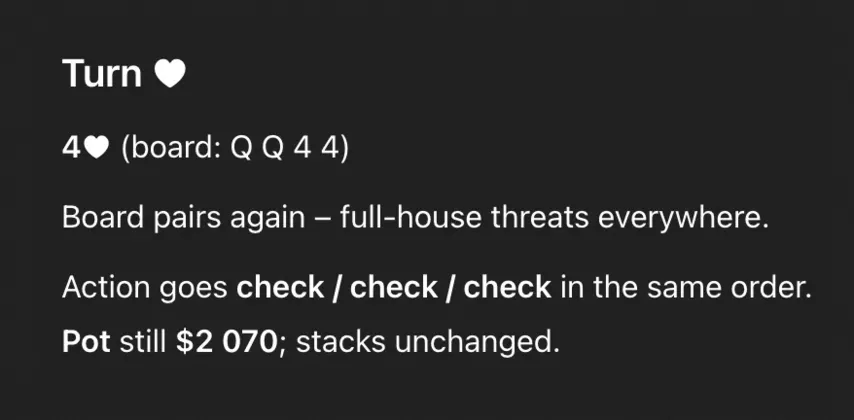

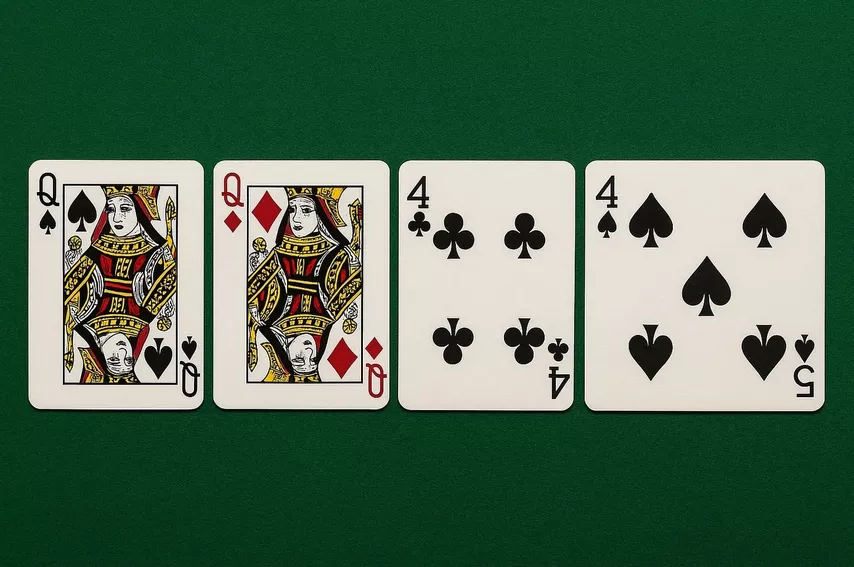

PD: Por cierto, la ilustración para este artículo también nos la proporcionó ChatGPT:

No me gustan las imágenes generadas por IA, pero esta captura a la perfección la esencia de mi ensayo. Le pedí al modelo que dibujara un board con cinco cartas: . Pero al final algo salió mal.